音视频同步实现拆解:Audio Master 策略在 Qt + FFmpeg 播放器中的落地

音视频同步实现拆解:Audio Master 策略在 Qt + FFmpeg 播放器中的落地

系列导航

1. 先明确:同步到底在解决什么

播放器的不同链路速度不一致:

- 解封装速度不稳定(尤其 RTSP)。

- 音频和视频解码耗时不同。

- 渲染和音频设备输出存在缓冲延迟。

同步的目标不是“每帧精确同时”,而是“观感可接受且长期稳定”。

2. 为什么优先选 Audio Master

这个项目采用音频主时钟(AudioMaster)策略,核心原因:

- 音频设备由系统时钟驱动,连续性最好。

- 人耳对音频抖动更敏感,优先保证声音稳定。

- 视频可以丢帧/等待做补偿,音频连续性代价更高。

3. 同步组件设计

同步被集中在 AVSynchronizer,而不是散在各模块。

关键状态:

audioClockvideoClockexternalClocksyncMode(默认 AudioMaster)- 阈值参数:

m_syncThreshold、m_maxFrameDelay

对应文件:

AVSynchronizer.hAVSynchronizer.cpp

4. 当前时钟更新链路

4.1 音频时钟来源

音频解码后计算 framePts,通过信号上报:

1 | AudioDecoder::decode |

4.2 视频时钟来源

视频帧渲染前后更新 videoPtsUpdated,用于监控与备用同步模式。

关键接线代码(Player::open())如下:

1 | connect(m_audioDecoder.get(), &AudioDecoder::audioPtsUpdated, this, [this](double pts) { |

代码阅读提示:

[2]是 Audio Master 的核心输入。[4]不是主时钟,但用于监控和备用同步模式切换。

5. 视频侧同步判定

视频线程每帧会做一件关键事:

1 | delay = framePts - audioClock |

然后根据 delay 决定动作:

delay < -0.5:视频明显落后,连续多帧则丢帧追赶。0 < delay < 1:视频略领先,sleep 等待音频追上。- 其余情况:立即渲染。

这就是“以音频为基准拉齐视频”的核心。

对应代码(VideoDecoder::decode()):

1 | double pts = frame->best_effort_timestamp != AV_NOPTS_VALUE |

代码阅读提示:

[2]这一行是同步策略的判定核心。[3][4]是“落后追赶”路径;[6]是“超前等待”路径。0.5与5(连续帧数)就是当前可调的体验参数。

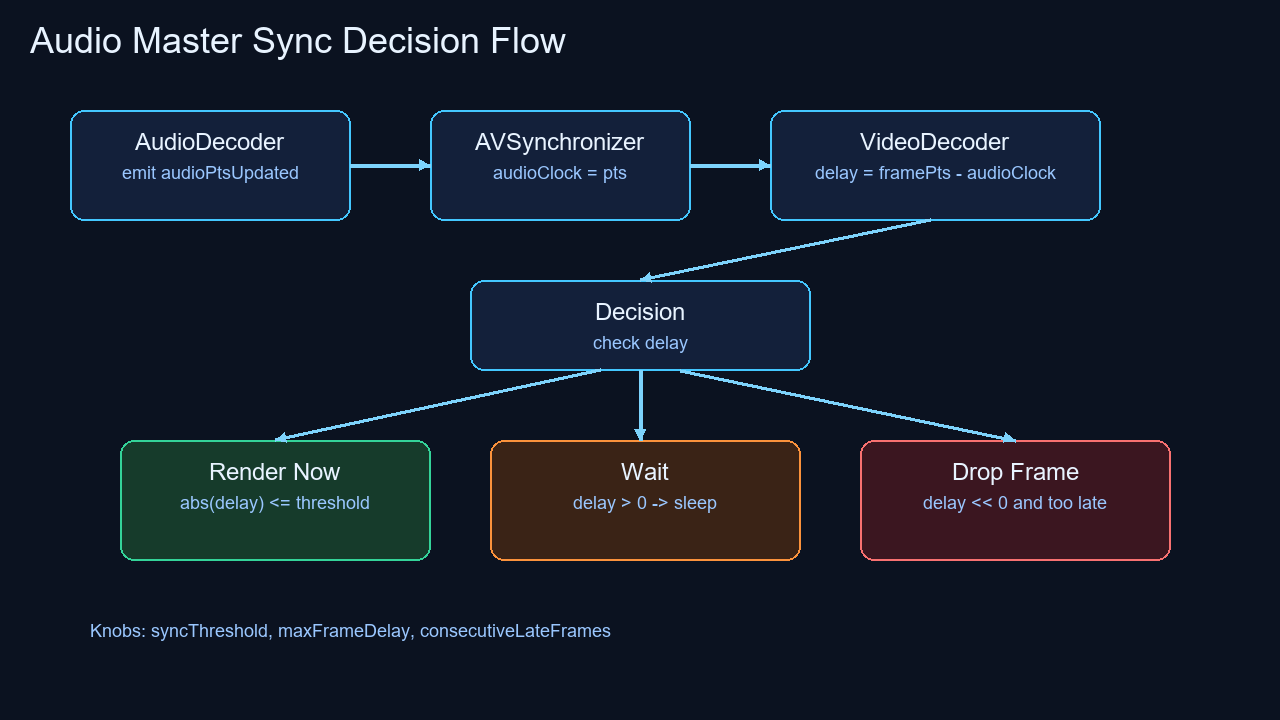

图解:Audio Master 判定流程

图注:音频侧持续推进主时钟,视频侧按 delay = framePts - audioClock 进入“立即显示 / 等待 / 丢帧”三选一分支。

6. 与通用算法的关系

从工程角度看,这套逻辑是简化版的“软同步控制器”:

- 领先就等(wait)。

- 落后就丢(drop)。

- 在阈值内直接显示(display now)。

AVSynchronizer::calculateVideoDelay() 也提供了通用延迟计算能力(返回等待时长或丢帧信号),便于后续把视频线程的策略统一收敛到一个函数里。

其核心逻辑如下(AVSynchronizer.cpp):

1 | double AVSynchronizer::calculateVideoDelay(double framePts) |

代码阅读提示:

[1][2][3]说明该同步器天然支持三种主时钟模式。[4][5][6]把判定结果标准化为三种动作,调用方易于落地。

7. 当前实现的优势

- 逻辑直观:代码短、问题定位快。

- 适配实时流:在 RTSP 抖动场景下,丢帧追赶有效。

- 可扩展:已经预留

VideoMaster与ExternalClock模式。

8. 生产可优化点

8.1 用“音频设备实际播放时刻”修正时钟

目前音频时钟主要由解码 PTS 驱动。更稳健的做法是结合 QAudioOutput 缓冲深度估算“真实播放头位置”,减少音画轻微漂移。

8.2 阈值分层

建议把同步阈值拆成三段:

small_threshold:轻微误差,直接渲染。wait_threshold:可等待区间。drop_threshold:必须丢帧区间。

这样不同帧率、不同网络条件下更好调。

8.3 连续丢帧保护

当前已有 m_consecutiveLateFrames。建议再加“最大连续丢帧窗口”,避免极端网络下视频长时间不可见。

8.4 统一同步入口

目前视频侧有一套延迟判断,AVSynchronizer 也有 calculateVideoDelay()。建议保留单一真值来源,降低维护分叉风险。

9. 一个更清晰的同步伪代码

1 | audio_clock = get_audio_clock() |

10. 调参建议(实战)

- 本地文件优先降低丢帧阈值,提升流畅感。

- RTSP 场景适当放宽等待阈值,减少抖动。

- 高帧率视频(60fps)可收紧

max_frame_delay,防止拖尾。 - 日志中打印

audioClock/videoPts/diff,先观察再调参。

11. 小结

音视频同步不是“一个公式”,而是“策略 + 阈值 + 观感”的平衡。

这个项目已经具备了可用的 Audio Master 基础形态。下一步重点是:

- 统一延迟计算入口。

- 引入音频设备真实播放进度。

- 做场景化阈值配置(本地/RTSP)。

做到这三点,同步稳定性会明显提升。